GPT

2025-04-19 09:32

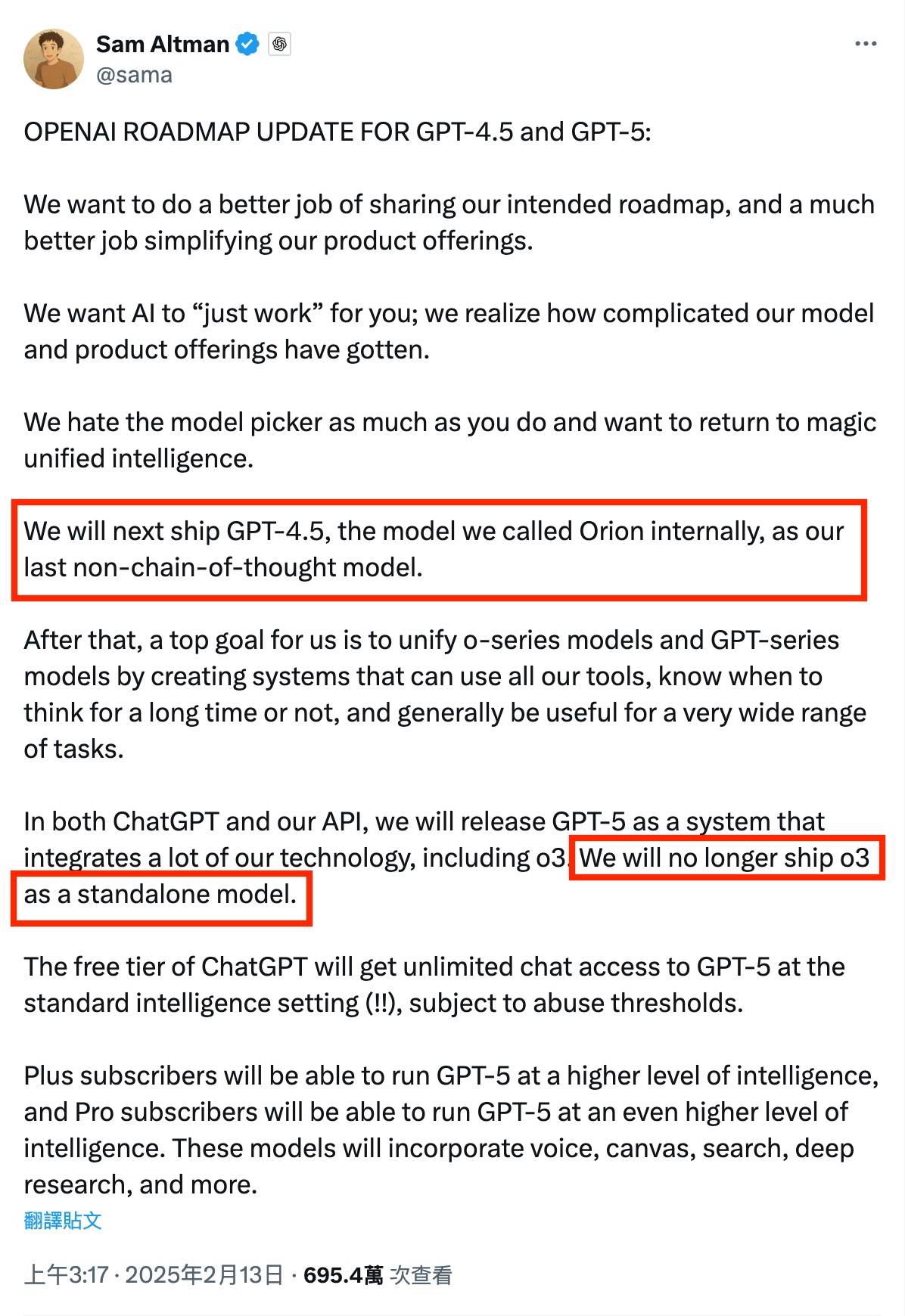

最近在Openai有很多工作。在3月底,GPT-4O土著产生的图像启动后,Openai在4月15日清晨(北京时间)推出了GPT-4.1系列的新模型,取代了前GPT-4型号。在今天(4月17日)清晨,OpenAI继续推出两个新的O。o3和O4-Mini不仅具有更强的推理能力,它支持图像在“思考过程”中直接集成,而且还支持可能独立使用所有chatgpt工具的推理模型。它被正式称为:“我们(OpenAI)至今已发布的最聪明的模型代表了Chatgpt能力的飞跃。” “我们发布的最聪明的模型(Openai)代表了卡卡的飞跃。”我们不谈论是否有些人在乎。 Openai首席执行官Sam Altman今年2月在X平台上公开揭示了内部路线图今年,指出GPT-4.5(Orion)将是“最后的非推断(思维链)GPT-4.5。下一个GPT-5将包括GPT系列和O系列模型:“ O3将不再以独立模型启动。”图片,但现在,山姆(Sam)的诺言似乎不仅释放了新的GPT-4.1非注视模型,而且还独立地推出了O3推理模型OpenAI模型实际上是普通的Chatgpt用户,但许多开发人员还认为,OpenAI模型阵容使其“很难选择”,尽管OpenAi在过去两天中发布了许多新型号,但至少有一些“旧型号”在同一时间被裁定。Enai宣布将在4月30日在Chatgpt上完全启动GPT-4模型,并删除API(用于开发人员)中的GPT-4.5预览版。扩展全文

作为一般基本模型,GPT-4.1实际上分为旗舰,迷你版和纳米版本的版本,该版本支持数百万个令牌上下文,并且在性能,Gastos和速度方面,它比当前最重要的GP更好。 T-4O系列模型,但目前只是为开发人员启动API。

但是,如果GPT-4.1代表Openai,O3和O4-Mini的电流,则可以代表Openai的未来。作为对识别模型技术途径的OpenAI探索的最新成就,O3和O4-Mini是第一个真正整合思想链中图像理解能力的人。

照片/Openai

简而言之,它不仅识别信息,而且还包括在思考过程中并成为完整逻辑C的一部分的这些视觉输入海恩。与GPT-4O这样的多模型模型不同,尽管GPT-4O可以“查看图片”,但有关提供自然语言响应的更多信息,同时处理O3和O4-Mini映像是为了解决问题,这是推理的一部分。

同时,正如最强的官方认证模型O3一样,也是第一个拨打所有CANGGPT工具的理解模型,包括搜索网络,Python,图像生成,代码解释器,文件读取等以及延迟和成本为O1,O3在CANTGPT中实现了更高的性能。

但是实际的表现仍然是体验的结果。

Openai的“最强推理”:真的

为了理解模型,推理能力是自然的优先事项。让我们首先得到一个道德推理问题,该问题将测试模型的推理能力。我们还比较了两个顶级模型,即DeepSeek-R1和Gemini-7.5-Pro。

但是在答案表示之前,O3最令人惊奇的是,思维过程的严格而流利的推导。在骗子中Trast,DeepSeek-R1思考过程似乎有点摩ah婆巴,一遍又一遍地。已经很长时间了,但是最终的答案很难享受。

照片技术/LEI

在DeepSeek-R1的回应中,它实际上只是回答了“愤怒引起的”,而没有回答“崩溃的原因”。在Gemini-7.5-Pro的回应中,尽管“女儿说谎”的因素是进一步的推理,但也很难导致“父亲的堕落”。

照片技术/LEI

O3完美地捕捉了“色盲”的基本判断,并进一步捕获了基于生物遗传知识的最终解释。这里应该提到的是,DeepSeek-R1实际上提到了心理过程中“色盲”的点,但它认为它在推导方面并不有效。

此外,O3和O4-Mini的重大成功还包括思维链中的视觉功能,这比阿里巴巴推出的Visual Reason QVQ-MAX模型更进一步。

您可以将图片上传到该机场将确定终端建筑物,乘客流和身份系统,然后结合您的问题以完成对空间流量问题的计划或评估。 “此图像不是输入材料,而是推理所涉及的变量的设计,也是过去或一系列推理模型的事物。

更重要的是,它可以根据实时图像考虑分析技术。

例如,最近AI行业的关键因素之一是几天前刚刚启动了MCP服务器的支付,使AI代理商可以打开“货币化”付款链接。我拍摄了演示的视频,并将其发送给O3,该视频要求“ keyke进行视频显示技术”,甚至没有说任何背景信息。

照片技术/LEI

在实际试验中,O3将从不同时期拿起关键框架来了解视频,并结合自己的评论和推理以及S在网络中杀死,清楚地找到了Alipay的“ McPerver付款”,并通过信息研究了Alipay的“ McPserver付款”的基本意义。

不仅如此,在有关简短视频优化的测试中,O3还被要求研究背景数据并结合视频故事板以优化方法。该输出不仅涵盖了基本技术,例如“ 3秒钟的维护,节奏编辑,挂钩钩子”,而且还对应于视觉节奏的特定建议。

照片技术/LEI

从这一点上开始,O3是具有一定美学和体验的“专业创造者”,并且可以针对视频的实际内容,而不是“简单的模板集”。

从这些试验中,O3还将找出何时学习,何时搜索,何时调用工具以及何时进行总结。这种“主动思考 +链链”是当今大型模型集体演变的重要方向。

因此,这确实是最聪明的模型Openai这一天?从当前的经验来看,它确实应该得到其名称,与不同的理解模型相比,它甚至是最强的。

最后写

使用O3后,您会感到最大的感觉是您认为它确实理解了工作 - 只是不了解您的目标。它清楚地看到了思维过程,并且O3具有视觉理解,工具调用和强大的推理能力。

因此,使用O3后,有关GPT-5的猜测变得更加具体。

Sam Altman明确表示,GPT-5将包括GPT和O系列系列,根据最新消息,GPT-5发射时间通常在今年夏天被锁定。在时间方面,GPT-4.1/GPT-4.5和O3/O4-Minini可能是最后一代“独立”模型,也是主要力量“综合”。

如果两者实际上是整合的,它将是一个单一的型号,可以阅读数百万个令牌,以模式行动并自由安排工具让连锁店思考?无论如何,这实际上是未来几个月内AI行业中已久的悬念之一。回到Sohu看看更多

最近在Openai有很多工作。在3月底,GPT-4O土著产生的图像启动后,Openai在4月15日清晨(北京时间)推出了GPT-4.1系列的新模型,取代了前GPT-4型号。在今天(4月17日)清晨,OpenAI继续推出两个新的O。o3和O4-Mini不仅具有更强的推理能力,它支持图像在“思考过程”中直接集成,而且还支持可能独立使用所有chatgpt工具的推理模型。它被正式称为:“我们(OpenAI)至今已发布的最聪明的模型代表了Chatgpt能力的飞跃。” “我们发布的最聪明的模型(Openai)代表了卡卡的飞跃。”我们不谈论是否有些人在乎。 Openai首席执行官Sam Altman今年2月在X平台上公开揭示了内部路线图今年,指出GPT-4.5(Orion)将是“最后的非推断(思维链)GPT-4.5。下一个GPT-5将包括GPT系列和O系列模型:“ O3将不再以独立模型启动。”图片,但现在,山姆(Sam)的诺言似乎不仅释放了新的GPT-4.1非注视模型,而且还独立地推出了O3推理模型OpenAI模型实际上是普通的Chatgpt用户,但许多开发人员还认为,OpenAI模型阵容使其“很难选择”,尽管OpenAi在过去两天中发布了许多新型号,但至少有一些“旧型号”在同一时间被裁定。Enai宣布将在4月30日在Chatgpt上完全启动GPT-4模型,并删除API(用于开发人员)中的GPT-4.5预览版。扩展全文

作为一般基本模型,GPT-4.1实际上分为旗舰,迷你版和纳米版本的版本,该版本支持数百万个令牌上下文,并且在性能,Gastos和速度方面,它比当前最重要的GP更好。 T-4O系列模型,但目前只是为开发人员启动API。

但是,如果GPT-4.1代表Openai,O3和O4-Mini的电流,则可以代表Openai的未来。作为对识别模型技术途径的OpenAI探索的最新成就,O3和O4-Mini是第一个真正整合思想链中图像理解能力的人。

照片/Openai

简而言之,它不仅识别信息,而且还包括在思考过程中并成为完整逻辑C的一部分的这些视觉输入海恩。与GPT-4O这样的多模型模型不同,尽管GPT-4O可以“查看图片”,但有关提供自然语言响应的更多信息,同时处理O3和O4-Mini映像是为了解决问题,这是推理的一部分。

同时,正如最强的官方认证模型O3一样,也是第一个拨打所有CANGGPT工具的理解模型,包括搜索网络,Python,图像生成,代码解释器,文件读取等以及延迟和成本为O1,O3在CANTGPT中实现了更高的性能。

但是实际的表现仍然是体验的结果。

Openai的“最强推理”:真的

为了理解模型,推理能力是自然的优先事项。让我们首先得到一个道德推理问题,该问题将测试模型的推理能力。我们还比较了两个顶级模型,即DeepSeek-R1和Gemini-7.5-Pro。

但是在答案表示之前,O3最令人惊奇的是,思维过程的严格而流利的推导。在骗子中Trast,DeepSeek-R1思考过程似乎有点摩ah婆巴,一遍又一遍地。已经很长时间了,但是最终的答案很难享受。

照片技术/LEI

在DeepSeek-R1的回应中,它实际上只是回答了“愤怒引起的”,而没有回答“崩溃的原因”。在Gemini-7.5-Pro的回应中,尽管“女儿说谎”的因素是进一步的推理,但也很难导致“父亲的堕落”。

照片技术/LEI

O3完美地捕捉了“色盲”的基本判断,并进一步捕获了基于生物遗传知识的最终解释。这里应该提到的是,DeepSeek-R1实际上提到了心理过程中“色盲”的点,但它认为它在推导方面并不有效。

此外,O3和O4-Mini的重大成功还包括思维链中的视觉功能,这比阿里巴巴推出的Visual Reason QVQ-MAX模型更进一步。

您可以将图片上传到该机场将确定终端建筑物,乘客流和身份系统,然后结合您的问题以完成对空间流量问题的计划或评估。 “此图像不是输入材料,而是推理所涉及的变量的设计,也是过去或一系列推理模型的事物。

更重要的是,它可以根据实时图像考虑分析技术。

例如,最近AI行业的关键因素之一是几天前刚刚启动了MCP服务器的支付,使AI代理商可以打开“货币化”付款链接。我拍摄了演示的视频,并将其发送给O3,该视频要求“ keyke进行视频显示技术”,甚至没有说任何背景信息。

照片技术/LEI

在实际试验中,O3将从不同时期拿起关键框架来了解视频,并结合自己的评论和推理以及S在网络中杀死,清楚地找到了Alipay的“ McPerver付款”,并通过信息研究了Alipay的“ McPserver付款”的基本意义。

不仅如此,在有关简短视频优化的测试中,O3还被要求研究背景数据并结合视频故事板以优化方法。该输出不仅涵盖了基本技术,例如“ 3秒钟的维护,节奏编辑,挂钩钩子”,而且还对应于视觉节奏的特定建议。

照片技术/LEI

从这一点上开始,O3是具有一定美学和体验的“专业创造者”,并且可以针对视频的实际内容,而不是“简单的模板集”。

从这些试验中,O3还将找出何时学习,何时搜索,何时调用工具以及何时进行总结。这种“主动思考 +链链”是当今大型模型集体演变的重要方向。

因此,这确实是最聪明的模型Openai这一天?从当前的经验来看,它确实应该得到其名称,与不同的理解模型相比,它甚至是最强的。

最后写

使用O3后,您会感到最大的感觉是您认为它确实理解了工作 - 只是不了解您的目标。它清楚地看到了思维过程,并且O3具有视觉理解,工具调用和强大的推理能力。

因此,使用O3后,有关GPT-5的猜测变得更加具体。

Sam Altman明确表示,GPT-5将包括GPT和O系列系列,根据最新消息,GPT-5发射时间通常在今年夏天被锁定。在时间方面,GPT-4.1/GPT-4.5和O3/O4-Minini可能是最后一代“独立”模型,也是主要力量“综合”。

如果两者实际上是整合的,它将是一个单一的型号,可以阅读数百万个令牌,以模式行动并自由安排工具让连锁店思考?无论如何,这实际上是未来几个月内AI行业中已久的悬念之一。回到Sohu看看更多 相关推荐

» GPT

Copyright © 2024-2026 AG真人百家家乐app_AG真人百家家乐网站 版权所有

+86-123-4567

+86-123-4567 天朝天堂路99号

天朝天堂路99号